Web Crawler چیست؟ + انواع و نحوه کار خزنده وب

در این مقاله میخوانید

Web Crawler چیست؟ اگر صاحب وبسایت هستید و اطلاعات ابتدایی در مورد سئو دارید، احتمالاً با این سؤال روبهرو شدهاید. کار ربات های خزنده این است که بین کل محتواها در اینترنت بخزند و تشخیص دهند که هر صفحهی وب در مورد چه چیزی حرف میزند؟ این کار باعث میشود تا وقتی کاربران عبارتی را در گوگل جستجو میکند، بهترین نتیجه به آنها نشان داده شود. اگر این موضوع و نحوهی انجام آن برایتان جذاب است، این مطلب از آموزش سئو بلاگ پارس پک را از دست ندهید. در این مقاله میخواهیم شما را با انواع خزنده وب و نحوه کار آنها آشنا کنیم، با ما همراه باشید.

Web Crawler چیست؟

وب کراولر یا خزنده وب (Web Crawler) رباتی اینترنتی است که بهطور خودکار اطلاعات وبسایتها را مرور کرده و صفحات سایت را بر اساس معیارهای مختلف برای فهرستبندی در موتورهای جستوجو بررسی میکند.

این رباتها بهصورت خودکار صفحات وبسایتها را مرور و اطلاعات آنها را جمعآوری میکنند. هدف این خزندهها، ایندکس کردن صفحات وب در موتورهای جستوجو است تا کاربران بهراحتی و با سرعت بالا به اطلاعات مورد نیاز خود دست پیدا کنند.

وظایف رباتهای خزنده

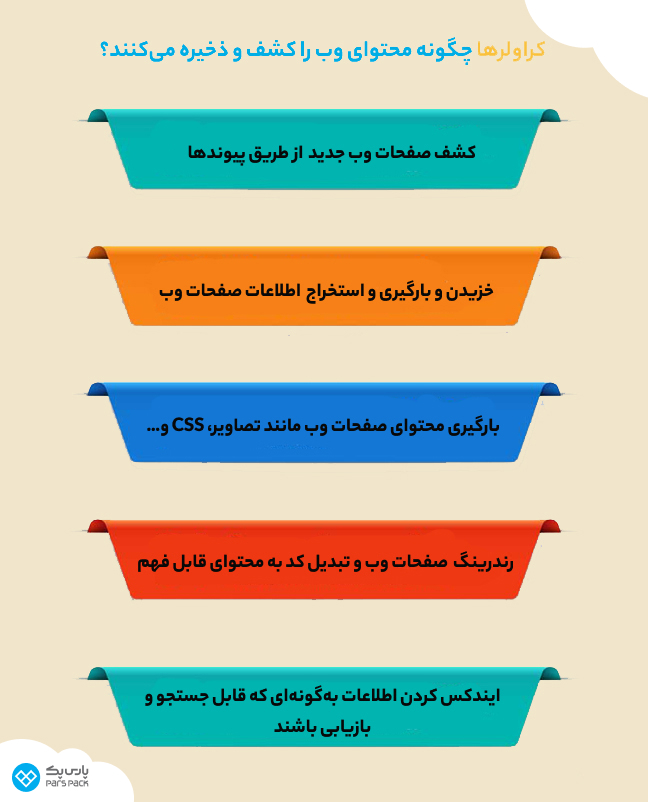

قبل از هر چیز بهتر است ببینیم که وظیفهی خزنده وب چیست. خیلی ساده اگر بخواهیم توضیح دهیم، نحوه کار Crawler به این صورت است که این رباتهای فوق هوشمند، همهی محتواهای منتشر شده در فضای اینترنت را دانلود و فهرستبندی میکنند. این فهرست کردن، همان مفهومی است که شما آن را با نامِ Index شدن صفحات وب میشناسید. هدف خزندهها در این مرحله شناسایی صفحات و استخراج موضوعاتی است که در هر صفحه به آنها پرداخته شده است.

نحوه کار خزنده وب، دقیقاً مثل یک مسئول یک کتابخانهی نامنظم است که باید بین قفسههای مختلف کتاب گشت بزند، همهی کتابها و موضوعشان را بررسی کند و دست آخر، همهی این اطلاعات را جایی دستهبندی کند تا پیدا کردن کتابها سادهتر شود.

اگرچه مثال ارائه شده تا حدی نحوه کار Crawler را به تصویر میکشد، اما این کتابخانه با چالشهایی نیز مواجه است. برای مثال، تشخیص دقیق محتوای هر صفحه از کتاب فیزیکی یا وبسایت برای مسئول کتابخانه و خزنده وب دشوار است.

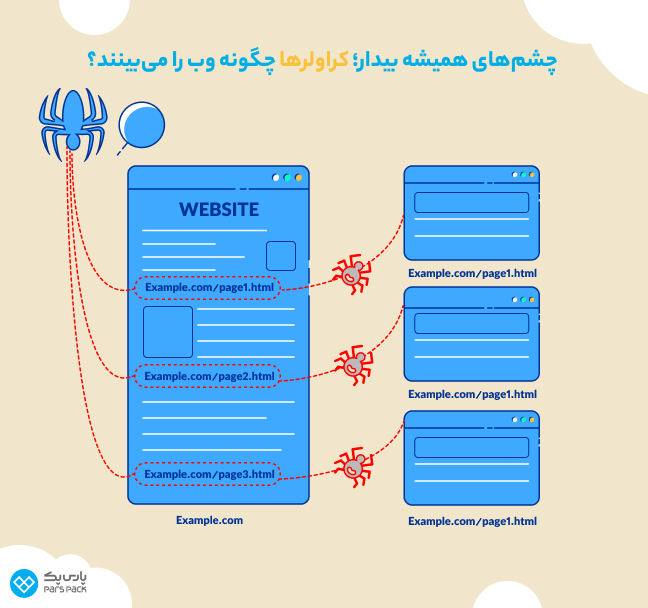

نکته مهم دیگر این است که خزندههای وب از چه روشهایی برای یافتن صفحات استفاده میکنند؟ ربات های خزنده کارشان را با یک مجموعهی خاص از صفحات وب شروع میکنند و سپس با دنبال کردن پیوندهای آن، صفحات دیگر را شناسایی میکنند و به همین ترتیب، شناسایی و ایندکس کردن صفحات دیگر هم انجام میشود.

تفاوت کراولینگ و ایندکسینگ

تا این قسمت میدانیم که Web Crawler چیست. نکاتی را هم در مورد ایندکس شدن صفحات یاد گرفتهایم. اما تفاوت کراولینگ و ایندکسینگ هنوز هم جای بحث دارد.

در واقع، فرایند کراولینگ یک مرحله قبلتر از ایندکسینگ اتفاق میافتد. یعنی انواع خزنده های وب که در بخش بعدی بیشتر در موردشان صحبت میکنیم، با همان روشی که توضیح دادیم، خودشان را وارد صفحات وب میکنند و شروع به جمعآوری اطلاعات هر صفحه میکنند و بعد به سراغ لینکهای بعدی قرار گرفته در همان صفحه رفته و همین روند برای این لینکها هم اتفاق میافتد.

به این ترتیب، نقشهی سایت (Site Map) تهیه شده و همه چیز برای ایندکسینگ صفحات محیا میشود. حالا تمام اطلاعاتی که ربات های خزنده از وبسایت جمعآوری کرده است، در یک پایگاه دادهی بزرگ به اسم Web Index قرار میگیرد. بنابراین، هر زمان که کاربر در مورد یک عنوان جستجو میکند، گوگل مثلِ همان مسئول کتابخانه، دقیقاً میداند که باید به کدام قفسه برود و کدام نتیجه را به کاربران نشان دهد.

اجازه دهید همینجا یک نتیجهگیری کلی داشته باشیم، کراولینگ به مرحلهی جمعآوری اطلاعات گفته میشود اما ایندکسینگ مرحلهی ذخیرهسازی و طبقهبندی دادهها بر اساس موضوعی است که در مورد آن صحبت میکنند.

۴ نمونه از انواع کراولر

بررسیها نشان میدهد که تا ژانویه ۲۰۲۲، حدود ۱ زتابایت (۱ تریلیون گیگابایت) محتوا روی اینترنت بارگذاری شده است. این یعنی اگر ربات های خزنده به داد انسانها نرسند، ما بین، انبوهی از دیتا مدفون میشویم! بنابراین منطقی است که اینجا هم به جملهی «هر کسی را بهر کاری ساختن» پایبند باشیم! بهطورکلی کراولرهای وب، بر اساس نوع کاری که انجام میدهند، به چند دستهی مختلف تقسیمبندی میشوند:

۱. کراولرهای عمومی (General-Purpose Crawler)

کراولرهای عمومی خط شکنِ خزیدن در میان صفحات وب هستند. این کراولرها اطلاعات را بهصورت گسترده از میانِ صفحات وب جمعآوری میکنند. احتمالاً اگر کسی از شما بپرسد که خزنده وب چیست، همین کراولرِ عمومی است که برای اولین بار به ذهن شما میآید. البته این پیشفرضِ ذهنی خیلی هم اشتباه نیست؛ چون کراولر اصلی موتورهای جستجو مثل گوگل بات یا بینگ بات، بیشتر دیتاهای خود را از همین کراولرها جمعآوری میکنند.

۲. کراولر بک لینک (Backlink Crawler)

بک لینک کراولرها نوعی از خزندههای وب هستند که وظیفهی شناسایی و جمعآوری تمام لینکهای خارجی وبسایت شما را بر عهده دارند. گوگل هم در ساختار خود این کراولرها را دارد و اگر از طریق وبسایتهای قدرتمند، به وبسایت شما لینک داده شود، به محتواهای منتشر شده توسط شما، اعتماد بیشتری میکند.

۳. کراولر مدیا (Media Crawler)

احتمالاً شما هم شنیدهاید که اضافه کردن محتواهای غیر متنی مثل عکس، ویدیو و یا پادکست، میتواند تاثیر قابل توجهی روی سئوی سایتِ شما داشته باشد. وظیفهی رصد کردن این نوع از محتواها بر عهدهی Media Crawlerها است.

۴. کراولر محتوا (Content Crawler)

کراولر محتوا یک قدم جلوتر از کراولر عمومی است و با تمرکز بر وبسایت شما به دنبالِ اخبار، مقالات و نوشتههایِ نابِ وبلاگتان میگردد و آنها را با دقتِ بالا جمعآوری میکند.

معرفی ویژگیها و کاربرها و آموزش بخشهای مختلف سرچ کنسول را در مقاله زیر بخوانید.

نحوه کار Crawler چگونه است؟

در این قسمت میخواهیم نحوه کار Crawler را بهصورت کامل بررسی کنیم. اگر شما قرار بود همه محتواهای منتشر شده در اینترنت را ببینید و آن را دستهبندی کنید، چهکار میکردید؟ با توجه به حجم بالای محتواهای منتشر شده بر بستر وب، آیا این کار شدنی است؟ دقت کنید که این یک سوال بنیادین است و پاسخ درست به آن میتواند به شما در درکِ عمیقتر عوامل مهم در خزیدن کراولرها کمک کند.

اولین نکتهای که باید به آن توجه کنید این است که ربات های خزنده، کار خودشان را از یک Seed یا لیستی از URLهای شناخته شده شروع میکنند و درونِ آنها میخزند و بعد هم لینکهایی که آنها به وبسایتهای دیگر دادهاند را بررسی میکنند و همینطور کارشان را جلو میبرند؛ دقیقاً مثلِ مورچههایی که میخواهند یک کلونی را برای خودشان بسازند!

جهان وب پویایی بیوقفهای دارد و سیل عظیمی از وبسایتها و محتواهای جدید بهطور مداوم در حال خلق هستند. خزندههای موتور جستجو برای همگام شدن با این پویایی، باید به طور خستگیناپذیر و بدون وقفه به کار خود ادامه دهند تا هیچ وبسایتی از قلم نیفتد و فرایند ایندکس بهطور کامل انجام شود.

سوال کلیدی این است که آیا همه وبسایتها از نظر خزندهها به یک اندازه مهم هستند؟ یا اینکه معیار خاصی برای تعیین دفعات بازدید خزندهها از یک وبسایت وجود دارد؟

پاسخِ همهی این موارد، بله است! یعنی کراولرها سیاستهایی دارند که بر اساس آنها ممکن است به یک وبسایت اهمیت بیشتری بدهند و به وبسایت دیگری کمتر توجه کنند. بنابراین باید بدانید که این موارد مهم از نظر Crawler چیست و چطور میتوانید وبسایتتان را بیشتر در معرض خزیدن کراولرها قرار دهید:

۱. اهمیت نسبی صفحهی وب

تقریباً اکثر کراولرهایی که در بخش قبل بررسی کردیم، قادر به پیمایش تمام محتوای قابل دسترس در وب نیستند؛ باید بگویم که نه تنها چنین سیاستی وجود ندارد، بلکه امکان اجرای آن نیز به هیچ وجه فراهم نیست. بنابراین اهمیت صفحهی وب برای کراولر باید بهطور شفاف مشخص شود تا در مورد خزیدن یا عدم خزیدن آن تصمیمگیری کند.

اینکه چه عواملی باعث میشود تا خزندهی حساسِ ما دلش بخواهد در وبسایت و صفحات وبسایت ما بخزد یا نه، به عوامل مختلفی بستگی دارد که از جمله مهمترین آنها میتوان به دو مورد زیر اشاره کرد:

- میزان بازدید از صفحهی وب

- تعداد لینکهایی که از سایتهای دیگر به صفحه داده شده است.

بنابراین هر چه صفحهی وب شما از طرف سایتهای معتبر بیشتری لینک بگیرد و تعداد افراد بیشتری هم از آن بازدید کنند، ربات های خزنده به این نتیجه میرسند که احتمالاً محتوایی هم که در این صفحه منتشر کردهاید، اعتبار بالایی دارد. این یعنی رویِ خوش کراولر و دقیقاً همان چیزی که شما به آن نیاز دارید.

۲. بازدید مجدد از همان صفحه

اگر شما دو بار به یک بوتیک برگردید، یعنی مشتریِ آن شدهاید! و این یعنی چیزی در این بوتیک وجود داشته که اولاً ارزش بازگشتن را داشته و ثانیاً در بوتیک دیگری آن را پیدا نکردهاید. عینِ همین قضیه هم در وبسایت وجود دارد!

بنابراین اگر بخواهیم بهطور ساده بگوییم که اثر بازدید مجدد از صفحه رویِ کارکرد Web Crawler چیست، باید به استراتژی کلی و البته سادهی گوگل برگردیم؛ استراتژیای که مبنای آن رضایت مخاطب است.

۳. استراتژی فایل Robots.txt

فایل Robots.txt نقشهی راهِ کراولرهایی است که میخواهند به وبسایت شما سر بزنند و در صفحههای مختلف آن بخزند. این فایل دقیقاً مثلِ تابلوی راهنمای یک ساختمان بزرگ است که به شما کمک میکند تا همهی اتاقهای ساختمان را بهسرعت شناسایی کنید.

فایل Robots.txt دقیقاً همین کار را در وبسایت شما انجام میدهد و به ربات های خزنده این امکان را میدهد تا بتوانند صفحات وبسایت شما را شناسایی و ایندکس کنند. با استفاده از این فایل کنترل کاملی بر خزیدن و ایندکس شدن صفحات سایت خود توسط رباتهای موتور جستجو خواهید داشت. به عبارت دیگر، میتوانید به رباتها بگویید که کدام صفحات را ایندکس و نمایش دهند و از خزیدن و ایندکس شدن کدام صفحات جلوگیری کنند.

برای آشنایی با الفبای سئو به زبان ساده و یادگیری زیروبم آن مقاله زیر را بخوانید.

تفاوت وب کراولینگ و وب اسکریپتینگ

بیایید اطلاعاتمان را تا این قسمت جمعوجور کنیم، ما الان میدانیم که خزنده وب چیست، انواع خزندهها را هم شناسایی کردیم و میدانیم که چطور کار میکنند. این نکته را هم در نظر داشته باشید که این فقط خزندههای گوگل نیستند که بین صفحات وب میخزند و اطلاعات را جمعآوری میکنند؛ رباتهای مختلف دیگری هم وجود دارند که توسط توسعهدهندگان وب برای اهداف متفاوت برنامهنویسی شده و همین کار را با اهداف مختلف انجام میدهند. همینجا است که تفاوت بین وب کراولینگ و وب اسکریپتینگ مشخص میشود.

مهمترین تفاوت بین وب کراولینگ و وب اسکریپتینگ این است که در وب اسکریپتینگ اطلاعات وبسایت بدون اجازهی صاحبِ آن، توسط یک ربات جمعآوری میشود. بنابراین میتوان به این نتیجه رسید که تقریباً در تمامی موارد، وب اسکریپتر بهدنبال اطلاعات از یک سری وبسایت خاص است تا به هدف خود دست پیدا کند. اما وب کراولر بین همهی صفحات در تمامی وبسایتها میخزد و هدفش هم جمعآوری اطلاعات برای اهداف مخرب نیست.

نکتهی مهم بعدی این است که وب اسکریپترها به اینکه در حینِ خزیدنشان، به سرور یا هاست شما فشاری وارد میشود یا نه اهمیتی نمیدهند. اما کراولرهای وب بهخصوص کراولرهایی که برای موتورهای جستجو کار میکنند، مسیر خود را دقیقاً بر اساس مسیر مشخص شده در فایل Robots.txt انتخاب میکنند؛ به این ترتیب، فشاری روی هاست وبسایت شما وارد نمیشود.

اهمیت وب کراولرها روی سئو سایت

هر چه تعداد محتواهای ایجاد شده بر بستر اینترنت بیشتر میشود، موتورهای جستجو هم قواعد سختگیرانهتری را برای نشان داده شدن محتوا برای کاربران در نظر میگیرند. مثلاً تا همین چند سال پیش، الگوریتمهای گوگل تا این اندازه سختگیرانه رفتار نمیکردند اما به هر حال اگر میخواهید در این میدان بازی کنید، باید قواعد بازی را هم رعایت کنید. بنابراین با توجه به اینکه یکی از مهمترین وظایف ربات های خزنده بررسی وبسایت شما و ایندکس کردن صفحات آن است، اگر میخواهید ترافیک ارگانیک را از موتورهای جستجو دریافت کنید، حتماً باید دقیقاً بر اساس اصولی که آنها در نظر دارند رفتار کنید.

جدول زیر شامل مهمترین خزندههای وب فعال در اینترنت است:

| نام ربات | موتور جستجوی توسعهدهنده |

| Googlebot | گوگل |

| Bingbot | بینگ |

| DockDockbot | DockDockGo |

| Slrup | یاهو |

| Baiduspider | Baidu |

| ExaBot | Exalead |

هاست وردپرس پارسپک؛ خانهای امن برای وبسایت شما

سرعت و امنیت هاست و همچنین موارد تکنیکال دیگر فاکتورهایی هستند که ربات های خزنده روی آن حساسیت زیادی دارند. اگر میخواهید هاستی داشته باشید که هم سرعت بالایی داشته باشد و هم برای وردپرس بهینه شده باشد و از طرف دیگر، یک تیم امنیتی کامل پشتیبانی آن را برای شما انجام دهند، همین حالا روی لینک زیر کلیک کنید و هاست وردپرس پارس پک را انتخاب کنید.

جمعبندی

Web Crawler چیست؟ خزندههای وب کلید دیده شدن وبسایتها در گوگل هستند. رباتهای خزنده برنامههای کامپیوتری هوشمندی هستند که در دنیای وب میگردند و محتواها را جمعآوری و دستهبندی میکنند و به کاربران در جستجوی اطلاعات یاری میرسانند.در این مطلب از آموزش کسبوکار اینترنتی بلاگ پارس پک به زبان ساده به این سوال پاسخ دادیم که خزنده وب چیست، چطور کار میکند و آیا فقط موتورهای جستجو هستند که از این خزندهها استفاده میکنند یا نه. اگر سوالی درباره ربانهای خزنده دارید، در بخش دیدگاهها نظراتتان را برای ما بفرستید تا بهسرعت به آنها پاسخ دهیم.

سؤالات متداول

۱. خزشگر چیست؟

خزشگرها یا رباتهای خزنده، برنامههای هوشمندی هستند که بهطور خودکار صفحات وب را پیمایش و کاوش میکنند. هر ربات وظیفهی مشخصی را بر اساس مجموعهای از دستورالعملها دنبال میکند.

۲. معروفترین Web Crawler چیست؟

معروفترین وب کراولرها، خزندههایی هستند که توسط موتورهای جستجو طراحی میشوند تا بتوانند صفحات مختلف وب را شناسایی و ایندکس کنند.

۳. انواع خزنده های وب کدام است؟

دنیای خزندههای وب تنوع شگفتانگیزی دارد. از خزندههای عمومی که همه چیز را میبلعند تا خزندههای متن و محتواهای مولتیمدیا هر کدام وظیفهای خاص بر عهده دارند.

با سلام واحترام

مطالب خوبی بود استفاده کردم. بنده یک سوال داشتم!!!

آیا موسسات و سازمان ها برای جمع آوری اطلاعات مورد نیاز خود و ایندکس آن باید نسبت به برنامه نویسی خزشگر یعنی ساخت آن اقدام کنند یا این که رباتهای وب خزی آماده ای هم برای این کار وجود دارد؟؟؟

آیا علاوه بر سایتها از رسانه ها یا شبکه های اجتماعی مانند لینکدین یا اینستاگرام و غیره ، هم می شود وب کراولینگ و ایندکسینگ کرد؟ چطوری؟

از پاسخ کامل جنابعالی قبلا ممنون و متشکرم.

با سپاس

با سلام خدمت شما دوست عزیز

خوشحالیم که مطلب براتون مفید واقع شده.

در رابطه با سوال اول شما برای خزش اطلاعات گوگل بهتره از GOOGLE API استفاده کنید.

و در رابطه با سوال دوم شما راه حل استفاده از ابزراهای سوشال لیسنینگ (Social listening) میباشد.