کرال باجت چیست؟ ترفندهای بهبود crawl budget

در این مقاله میخوانید

- Crawl Budget چیست؟

- چرا گوگل بودجه خزش را برای وبسایتها تعیین میکند؟

- نظر گوگل درباره اهمیت کرال باجت در وبسایتهای مخلتف چیست؟

- چه وبسایتهایی باید به کرال باجت اهمیت دهند؟

- نحوه عملکرد کرال باجت

- اهمیت کرال باجت در سئو

- نحوه بودجهبندی منابع گوگل برای وبسایتها

- چگونه بودجه خزش وبسایت را بررسی کنیم؟

- بهترین روشهای بهبود کرال باجت

- اشتباهاتی که بودجه خزش را هدر میدهد!

- گزارش بودجه خزش از گوگل سرچ کنسول

- آمارگیری از وضعیت کرال باجت با ابزارهای سئو

- جمعبندی

- سؤالات متداول

بودجه خزش (Crawl Budget)، پارامتری است که تعیین میکند صفحات شما با چه سرعتی در پایگاهداده گوگل ایندکس میشود. اگر صفحات جدید یا تغییرات صفحات قبلی وبسایتتان، با تأخیر زیاد در نتایج گوگل نشان داده میشود، احتمالاً به افزایش کرال باجت نیاز دارید. در این راهنما از بخش آموزش سئو سایت پارسپک همراه ما باشید تا مفهوم کرال باجت و اهمیت آن در سئو بهطور کامل آشنا شوید. سپس با پارامترهای تعیینکننده بودجه خزش آشنا شده و مراحل دقیق این فرایند را ببینید. همچنین ضمن ارائه راهکارهای عملی برای بهبود کرال باجت و اشاره به اشتباهات رایج هدررفت آن، نحوه بررسی این پارامتر و آنالیز گزارش آن را در ابزارهای مختلف یاد بگیرید.

Crawl Budget چیست؟

بودجه خزش (Crawl Budget)، تعداد صفحاتی است که رباتهای گوگل (Googlebot) میتواند در یک بازه زمانی مشخص، بخزد. منظور از خزش (Crawling) فرایندی است که در آن، رباتها اطلاعات صفحات وب را بازدید و جمعآوری میکند. این فرایند در حالت ایدهآل منجر به ایندکس (index) شدن صفحات در پایگاهداده گوگل میشود (بهمعنی نمایش صفحات در نتایج گوگل)؛ اما گاهی ممکن است به دلایلی (مانند کیفیت پایین محتوا یا مشکلات فنی)، ایندکس انجام نشود.

بودجه خزش، نشان میدهد که گوگل (یا هر موتور جستجوی دیگری) چهقدر زمان و منابع را به یک وبسایت اختصاص دادهاست. بنابراین، این عدد در وبسایتهای مختلف، متفاوت است. برای مثال فرض کنید یک وبسایت ۵۰۰۰ صفحه دارد. میانگین صفحات خزیدهشده روزانه آن نیز برای مثال ۲۰۰ صفحه است. در این صورت، ۲۵ روز طول میکشد تا گوگل کل صفحات را کرال کند و این زمان زیادی است!

حالا فرض کنید همین وبسایت با پیادهسازی تکنیکهایی که پایینتر آنها را میبینید، کرال باجت را به ۱۰۰۰ صفحه در روز برساند و کل وبسایت را در ۱۰ روز کرال کند. بهاینترتیب میتوان گفت بودجه خزش این وبسایت بسیار مطلوب است.

بودجه خزش (Crawl Budget)، تعیین میکند که گوگل چهقدر برای صفحات ما ارزش قائل است و چهقدر منابع را به آن اختصاص دادهاست. میزان این منابع، تعداد صفحاتی را مشخص میکند که رباتهای گوگل (Googlebot) در یک بازه زمانی میخزد. این خزش یا کاوش، پیشنیاز ایندکس شدن (Indexing) صفحات در پایگاهداده گوگل و بعد رتبهبندی آنها است. پیادهسازی چند تکنیک و اجتناب از چند اشتباه، میتواند کرال باجت را افزایش داده و سرعت رتبهبندی را نیز بالا ببرد.

چرا گوگل بودجه خزش را برای وبسایتها تعیین میکند؟

فضای وب بهسرعت در حال رشد است و میتوان آن را بینهایت در نظر گرفت. اما منابعی که گوگل برای خزش و ایندکس کردن صفحات در اختیار دارد، محدود است (از جمله تعداد رباتهای خزنده (Crawlers)، قدرت پردازش سرورها و ظرفیت ذخیرهسازی دادهها).

این محدودیتها باعث شده که گوگل به یک استراتژی کارآمد نیاز داشته باشد تا صفحاتی را که احتمالاً ارزشمندتر است، سریعتر خزش و ایندکس کند. به همین دلیل، گوگل برای هر وبسایت یک Crawl Budget مشخص تعریف میکند.

نظر گوگل درباره اهمیت کرال باجت در وبسایتهای مخلتف چیست؟

طبق گفته گوگل، بسیاری از وبسایتها لازم نیست نگران کرال باجت باشد؛ بهخصوص وبسایتهایی با کمتر از چند هزار URL که ساختارشان نیز استاندارد است. اما در مورد فروشگاههای آنلاین یا پلتفرمهای خبری و… با هزاران یا میلیونها صفحه، کرال باجت بسیار حائز اهمیت است.

در واقع برای سایتهای بزرگتر با تعداد صفحات بیشتر، مدیریت بهینه بودجه خزش میتواند به بهبود ایندکسشدن صفحات کمک کند. در ادامه میبینید که کرال شدن یک صفحه، پیشنیاز رتبهبندی آن است. بنابراین، اگر وبسایتهای بزرگ بودجه خزش پایینی داشته باشد، صفحات آن دیرتر کرال میشود.

چه وبسایتهایی باید به کرال باجت اهمیت دهند؟

پاسخ این سؤال را میتوان در دو فاکتور خلاصه کرد: تعداد صفحات و میزان تغییر محتواهای وبسایت. بر این اساس، وبسایتهایی با مشخصات زیر باید به بودجه خزش اهمیت ویژهای دهد:

- وبسایتهای بزرگ (بیش از حدود ۱ میلیون صفحه منحصربهفرد) با محتوایی که حداقل یک بار در هفته تغییر میکند.

- وبسایتهای متوسط یا بزرگ (بیش از حدود ۱۰۰۰۰ صفحه منحصربهفرد) با محتوایی که بهصورت روزانه تغییر میکند.

- وبسایتهایی که صفحات زیادی از آنها در گوگل سرچ کنسول (Google Search Console) پیام «Discovered – currently not indexed» را گرفتهاست. یعنی این صفحات توسط رباتها کشف شده؛ اما هنوز ایندکس نشدهاست.

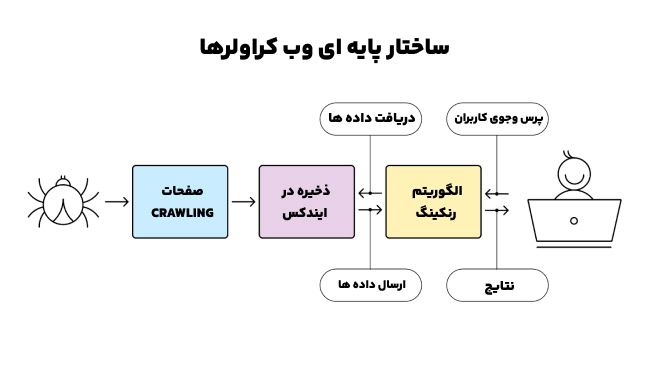

نحوه عملکرد کرال باجت

رباتهای گوگل (Googlebot) طی مراحلی مشخص، صفحات را برای خزیدن پیدا و اولویتبندی میکند. سپس بر اساس نتیجه خزش، آنها را ایندکس و رتبهبندی میکند. بعضی از این مراحل به جای این که بهصورت مستقل برای هر صفحه انجام شود، ممکن است برای چند صفحه بهصورت موازی انجام شود. در ادامه این مراحل را میبینید.

۱- کشف (Discovery)

رباتها در این مرحله، از وجود یک URL جدید یا تغییرات صفحات قبلی آگاه میشود. این کشف میتواند از طریق لینکسازیها، نقشه سایت (Sitemap) یا درخواستهای ایندکس مستقیم (در گوگل سرچ کنسول) انجام شود.

۲- دسترس به فایل Robots.txt

رباتها با خواندن این فایل، بررسی میکند که آیا این URL مجوز خزیدن دارن یا خیر. اگر مجوز نداشته باشد، از این صفحه رد میشود. اما اگر مجاز باشد، در همین صفحه به مرحله بعدی میرود.

۳- خزش

در این مرحله خزش آغاز شده و سه بخش اساسی از صفحه وب بررسی میشود:

- محتوا: به Googlebot کمک میکند که موضوع صفحه را تشخیص داده و بسته به کیفیت محتوای آن، بعداً صفحه را در پاسخ کوئری کاربر (User Query) در رتبه شایستهای نمایش دهد. استفاده استراتژیک از کلمات کلیدی و انتیتی (Entity) راهنمایی بزرگی برای رباتها است.

- کدها: رباتهای اسپایدار گوگل (Google Spider) بهعنوان زیرمجموعه کراولرهای گوگل، کدهای HTML صفحه را رصد میکند. در این مرحله، دو مورد کمک میکند که این رباتها صفحه را بهطور دقیقتر در نتایج جستجو نمایش دهد: دادههای ساختاریافته (Structured Data) و متادیتا (متاتایتل (Meta title)، توضیح متا (Meta Description) و…).

- لینکها: بررسی لینکهای href نیز بهعهده اسپایدرها یا عنکبوتهای گوگل است. ارتباطات داخلی و خارجی صفحه، با بررسی همین لینکها روشن میشود. این مرحله به رباتها کمک میکند که به جای خزش تصادفی، هوشمندانه و هدفمند صفحات وب را دنبال کند. URLهای بعدی نیز بر همین اساس به صف خزش اضافه میشود.

۴- ایندکس کردن (Indexing)

اطلاعات صفحه در فهرست ایندکس گوگل ذخیره میشود تا برای جستجوی کاربران در دسترس باشد (اطلاعاتی مانند محتوای اصلی، متادیتا (Meta Data) و ساختار صفحه). ایندکس یک پایگاهداده بزرگ است که تمامی صفحات کشفشده را برای بازیابی سریع (بهمنظور نمایش به کاربران) ذخیره میکند.

۵- تبادل اطلاعات

بین ایندکس شدن صفحه و رتبهبندی آن، مراحل واکشی اطلاعات (Fetch Data) و ارسال اطلاعات (Send Data) هم وجود دارد. طی این مراحل، اطلاعات برای بهبود رتبهبندی، دوباره از مرحله ایندکس بازیابی شده و اطلاعات جدید به سیستم فرستاده میشود. از طرفی این مراحل، به بهروزرسانی یا اصلاح اطلاعات و نتایج بر اساس الگوریتمهای جدید نیز اشاره دارد.

۶- رتبهبندی (Ranking)

الگوریتمهای گوگل صفحات ایندکسشده را بر اساس معیارهای مختلف رتبهبندی میکند. از جمله این معیارها میتوان به ارتباط محتواها با کوئری کاربران، کیفیت صفحه، سرعت بارگذاری و تجربه کاربری اشاره کرد.

۷- نمایش نتایج بر اساس جستجوی کاربر

حالا که صفحه رتبهبندی شده، همهچیز آماده است تا وقتی کاربر کوئری مد نظر خود را وارد میکند، صفحات در رتبههای مناسب به او نشان داده شود. این مرحله نهایی از فرایند کشف تا نمایش نتایج محسوب میشود.

۸- خزیدن صفحه بعدی

وقتی خزیدن URL فعلی تمام شد، رباتها همین مراحل را برای URL بعدی که در صف خزش است، تکرار میکند. این صف ممکن است شامل URLهای جدید، بهروزرسانیشده یا URLهایی باشد که در گذشته گوگل آنها را خزیده و نیاز به بررسی دوباره توسط کراولرها (crawlers) دارد. اولویتبندی URLها بر اساس عواملی مانند اهمیت صفحه، لینکسازیهای داخلی، دادههای ساختاریافته و سایر سیگنالهای سئو انجام میشود.

اهمیت کرال باجت در سئو

کرال باجت سایت به دو دلیل باید جدی گرفته شود: مزایایی که برای سایت دارد و آسیبهای احتمالی هدر رفت این بودجه. با خزیدن بهموقع صفحه، موتور جستجو محتوای جدید را بهسرعت بهروز کرده و آن را در نتایج جستجو قرار میدهد. در واقع با خزش سریعتر، استراتژیهای سئوی وبسایت، زودتر به ثمر مینشیند.

این سرعت بالا، باعث میشود که در نتایج جستجو سریعتر از رقبای خود حضور داشته باشید. بهویژه اگر وبسایت شما بهروزرسانیهای مکرر دارد (مثل وبلاگها یا فروشگاههای آنلاین)، بودجه خزش بالا، محتوای شما را همیشه در دسترس موتورهای جستجو و کاربران قرار میدهد. این امر به افزایش نرخ کلیک و ترافیک ارگانیک نیز منجر میشود.

اما اگر سرعت خزش گوگل پایین باشد، تأثیر مستقیم و غیرمستقیمی روی سئوی سایت میگذارد. کاهش ترافیک و عقب ماندن از رقبا، مهمترین نتایج این سرعت پایین است.

کنترل نکردن کرال باجت میتواند باعث کرال شدن صفحات بیارزش یا تکراری شود. در این صورت این منابع صرف صفحات اشتباهی شده و روند خزش صفحات مهمتر و رتبهبندی آنها، دیرتر پیش میرود. حتی ممکن است بعضی صفحات سهمی از منابع گوگل نداشته باشد و در عمل ایندکس نشود!

نحوه بودجهبندی منابع گوگل برای وبسایتها

گوگل بودجه خزش وبسایتهای مختلف را بر اساس دو پارامتر مهم تعیین میکند:

۱- میزان نیاز به خزش (Crawl Demand)

میزان نیاز به خزش (Crawl Demand)، یعنی یک وبسایت چهقدر به خزیدن نیاز دارد؟ هر چه تقاضا یا نیاز یک وبسایت بیشتر باشد، گوگل برای آن وقت بیشتری صرف میکند. وبسایتهایی با ویژگیهای زیر، اولویت بیشتری برای کرالینگ دارد و گوگل منابع بیشتری را برای خزش به آنها اختصاص میدهد:

- صفحات بیشتر

- بهروزرسانی منظم و بیشتر

- صفحات محبوبتر و باکیفیتتر

- صفحاتی با لینکسازی خارجی قویتر

۲- سرحد خزش (Crawl Capacity Limit/Host Load)

به حداکثر تعداد درخواستهای همزمانی که گوگل میتوان به سرور (Server) وبسایت ارسال کند (بدون این که سرور دچار اختلال شود) سرحد خزش (Crawl capacity limit/Host Load) میگویند. این سرحد، پارامتر دیگری را نیز تحت عنوان نرخ خزش (Crawl Rate Limit) تعیین میکند. نرخ خزش تعداد واقعی درخواستهای رباتهای گوگل برای خزیدن صفحه در یک ثانیه است.

اما گوگل چگونه سرحد خزش را تشخیص میدهد؟ با بررسی سیگنالهای زیر:

- زمان پاسخدهی سرور (Server Response Time): اگر سرعت پاسخدهی سرور وبسایت در روند خزش کم شود، گوگل فرض میکند که سرور تحت فشار قرار گرفته و نرخ خزش را کاهش میدهد. در مقابل، اگر سرور بهسرعت به درخواستها پاسخ دهد، احتمال افزایش نرخ خزش بیشتر است.

- زمان بین پاسخها (Latency Monitoring): گوگل تأخیر زمانی بین درخواست و دریافت پاسخ را بررسی میکند. اگر این تأخیر بیشتر شود، گوگل تعداد درخواستها را بهمرور کاهش میدهد.

- کدهای وضعیت (HTTP Status Codes): HTTP گوگل به کدهای وضعیتی مانند خطاهای ۵۰۰ (خطاهای سرور) حساس است. اگر تعداد زیادی از این خطاها مشاهده شود، نرخ خزش کاهش پیدا میکند تا فشار از سرور کم شود.

- سیگنالهای دستی سایت (Manual Signals): با ابزارهایی مانند گوگل سرچ کنسول یا با کدهای فایل Robots.txt میتوانید نرخ خزش گوگل را محدود کنید. گوگل بودجه خزش را بر اساس این تنظیمات در نظر میگیرد.

چگونه بودجه خزش وبسایت را بررسی کنیم؟

برای بررسی کرال باجت وبسایت خود، اول باید تعداد صفحات را بدانید. این عدد را میتوانید در ابزاری مانند Screaming Frog پیدا کنید. بعد وارد ابزار گوگل سرچ کنسول شوید. روی منوی «Settings» کلیک کرده و به بخش «Crawl stats» نگاه کنید. اینجا تعداد صفحات خزیدهشده در یک بازه زمانی مشخص را میبینید. بر اساس آن، میانگین تعداد صفحاتی که بهصورت روزانه کرال میشود را محاسبه کنید. برای مثال شاید آماری مانند 691 crawl requests (last 90 days) را داشته باشید. بنابراین، میانگین تعداد صفحات خزیدهشده در یک روز حدود ۸ صفحه است.

اما چه زمانی به افزایش کرال باجت نیاز است؟

تعداد کل صفحات وبسایت را بر میانگین تعداد صفحات خزیدهشده در یک روز تقسیم کنید. اگر به عددی حدود ۳ رسیدید (یعنی کل صفحات تقریباً ۳ برابر این میانگین بود)، وضعیت کرال باجت مطلوب است. اما اگر به عددی نزدیک ۱۰ یا بیشتر رسیدید، باید به فکر بهینهسازی بودجه خزش باشید.

بهترین روشهای بهبود کرال باجت

صفحات وب در حالت ایدهآل باید به ترتیب میزان اهمیتشان کرال شده و این روند با بیشترین سرعت ممکن انجام شود. خبر خوب این که با رعایت چند تکنیک در بهینهسازی وبسایت، میتوانید به این ایدهآل دست پیدا کنید که آنها را در ادامه میبینید.

۱- حذف ریدایرکتهای اضافه

ریدایرکتها بهترین راه نجات از مشکلاتی مانند خطاهای 404 است. اما وجود تعداد زیاد ریدایرکت، مسیر را برای خزیدن ربات گوگل دشوار میکند. در این میان، زنجیره ریدایرکت (Redirect Chains) از بزرگترین موانع مسیر کراولرها است.

زنجیره ریدایرکت زمانی رخ میدهد که صفحه A به صفحه B ریدایرکت شده و صفحه B به صفحه C و این روند ادامه دارد. اگر این زنجیره طولانی باشد، ممکن است رباتها مسیر را رها کند. گاهی نیز ممکن است این زنجیره از کنترل خارج شده و به یک حلقه بینهایت تبدیل شود. این امر باعث هدررفت شدید بودجه خزش میشود.

برای پیدا کردن زنجیره ریدایرکت، میتوانید از ابزارهایی مانند Screaming Frog استفاده کنید. کافی است روی تب «Reports» کلیک کرده و به مسیر «Redirects> Redirect Chains» بروید.

همینطور میتوانید در منوی سمت چپ ابزار گوگل سرچ کنسول روی گزینه «Pages» و بعد «Redirect Error» کلیک کنید. اینجا فهرستی از خطاهای ریدایرکت را مشاهده میکنید.

بعد از پیدا کردن آنها نیز تمام URLهای بین لینک اول و آخر را حذف کنید. برای مثال اگر یک زنجیره دارید که از هفت صفحه عبور کرده، صفحه اول را بهصورت مستقیم به صفحه هفتم ریدایرکت کنید.

۲- صرفهجویی در بودجه خزش

به رباتهای خزنده گوگل، دقیقاً بگویید که کدام صفحات را کرال کند یا از کرالکردن کدام صفحات بگذرد. بهاینترتیب بودجه خزش واقعاً صرف صفحات مهم میشود. بهترین روش این کار نیز تعیین URLهایی که میخواهید کرال نشود، در فایل Robots.txt است. صفحات مدیریتی سایت، صفحات محصول با فیلترهای داینامیک و… را میتوانید در این فایل برای خزندهها مسدود کنید.

یکی از تکنیکهای سئو فنی (Technical SEO) برای بهینهسازی بودجه خزش نیز استفاده درست از کدهای وضعیت HTTP (HTTP status codes) است. اگر صفحهای دارید که محتوای آن حذف شده و ریدایرکت استانداردی هم برایش در نظر ندارید، از کدهای زیر استفاده کنید:

- 404 (Not Found): رباتهای خزنده گوگل خزش اولیه صفحه را انجام میدهد؛ اما بهمرورزمان، خزش را کم یا متوقف میکند.

- 410 (Gone): این کد قویتر از 404 است و بهمعنی حذف دائمی صفحه است. بنابراین گوگل امید کمتری به اصلاح آن دارد و خزش دوباره آن را سریعتر متوقف میکند.

۳- بهینهسازی سرعت سایت

بالاتر درباره سرحد کرال باجت (Crawl Rate Limit) گفتیم و این که اگر سرور پاسخدهی کندی داشته باشد، گوگل تعداد درخواستهای خزش را کاهش میدهد. در مقابل، سرورهای سریعتر، به گوگل اجازه میدهد که صفحات بیشتری را در یک بازه زمانی بخزد.

برای افزایش سرعت سایت میتوانید از روشهای زیر استفاده کنید:

- استفاده از CND یا شبکه تحویل محتوا (Content Delivery Network)

- فشردهسازی محتوا با تکنیکهایی مانند Gzip

- حذف کدهای غیرضروری از کدهای CSS، JS و HTML

- فعالکردن کش (Cache) برای صفحات و منابع استاتیک

۴- بهروزرسانی نقشه سایت

بهروزرسانی نقشه سایت (Sitemap) راهنمایی عالی برای رباتها است. چراکه گوگل همیشه جدیدترین نسخه این نقشه را میخواند. ضمن این که اگر محتوای بهروزشدهای دارید، میتوانید از تگ <lastmod> برای آن استفاده کنید تا توجه گوگل به آن جلب شود.

۵- طراحی ساختار فکرشده برای وبسایت

ساختار وبسایت (Website Structure)، در واقع نقشه راه رباتهای خزنده گوگل است. بنابراین، به جای انتشار نامرتب صفحات و محتواها، یک ساختار برای آنها در نظر بگیرید. ساختار خوشهای (Pillar-Cluster) بهترین ساختار ممکن است که محتواها را بهشکل زیرمجموعهای مرتب میکند. این ساختار نقشه راه واضح و منظمی را به خزندههای گوگل داده و کار را برایشان راحتتر میکند.

لینکسازی داخلی نیز در ترسیم این نقشه راه تعیینکننده است. بالاتر اشاره کردیم که رباتهای خزنده از طریق لینکهای داخلی صفحات را در صف خزش اولویتبندی میکند. وجود لینکهای داخلی فکرشده، ناوبری سایت و کشف صفحات را بهمراتب روانتر میکند

۶- حذف محتواهای تکراری

محتوای تکراری در کنار هدر دادن Crawl Budget، رباتها را هم سردرگم میکند. میتوانید یکی از روشهای زیر را برای اصلاح این صفحات اجرا کنید:

- محتواهای تکراری مفید را تا جای ممکن ادغام و بعد ریدایرکت کنید.

- برای محتواهای تکراری بیارزش، کد وضعیت 404 یا 4011 را تعریف کرده یا آنها را در Robots.txt مسدود کنید.

اشتباهاتی که بودجه خزش را هدر میدهد!

ممکن است در فرایند بهینهسازی سایت خود عادتهایی داشته باشید که باعث هدر رفتن بودجه خزش شود. در ادامه مهمترینِ این اشتباهات را بههمراه راهحل میبینید.

۱- استفاده از تگ noindex به جای مسدودسازی رباتهای خزنده

شاید میخواهید از تگ noindex برای بعضی صفحات استفاده کنید. با تعریف این تگ، گوگل همچنان صفحه را خزش میکند؛ اما وقتی به تگ noindex میرسد، تصمیم میگیرد آن را ایندکس نکند. این یعنی Crawl Budget صرف بررسی صفحه شده، اما خروجی خاصی (مانند ایندکس شدن) ندارد. اما اگر صفحهای را در Robots.txt مسدود کنید، گوگل آن صفحه را نمیخزد. بنابراین، بودجه خزش به صفحات دیگر اختصاص داده میشود.

به منظور مطالعه بیشتر در زمینه ایندکس نشدن سایت در گوگل؛ (دلایل و راهحل رفع آنها) این مقاله از پارسپک را بخوانید:

۲- وجود صفحات یتیم

صفحات یتیم (orphan page) صفحاتی است که هیچ لینک داخلی به آنها داده نشدهاست. پیدا کردن این صفحات برای خزندهها سخت و زمانبر است. حتی ممکن است به دلیل سختی دسترسی، نادیده گرفته شود. این صفحات را میتوانید با ابزار Site Audit در Ahrefs یا SEMrush پیدا کنید. سپس از صفحاتی مناسب به آنها لینک داخلی بدهید.

۳- استفاده از پارامترهای URL غیرضروری

پارامترهای غیرضروری در URLها (Unnecessary URL Parameters)، میتواند باعث شود که گوگل صفحات مشابه را بهعنوان صفحات جداگانه، اما مشابه صفحه اصلی در نظر بگیرد (مانند ?page= و ?sort و…). در این صورت، تکتک آنها را کرال میکند. این پارامترها را میتوانید در بخش «URL Parameters» که زیرمنوی «Legacy tools and reports» است، مدیریت کرده و از خزشهای بیهوده جلوگیری کنید.

۴- بیتوجهی به لینکهای شکسته

لینکهای شکسته (Broken Links)، به لینکهایی گفته میشود که مقصد آنها یک صفحه مشکلدار (اغلب با ارور 404) است و دنبالکردن آنها هیچ ارزشی ندارد. از طرفی وجود این لینکها در یک صفحه، آن را در نظر گوگل بیاهمیت جلوه میدهد. گوگل نیز این صفحه را در اولویت پایینتری قرار میدهد. با ابزارهایی مانند گوگل سرچ کنسول یا Screaming Frog این لینکها را پیدا کرده و آنها را حذف کرده یا مقصدشان را تغییر دهید.

برای آشنایی با دلایل ایجاد لینک شکسته و نحوه رفع لینک آن روی لینک زیر کلیک کنید:

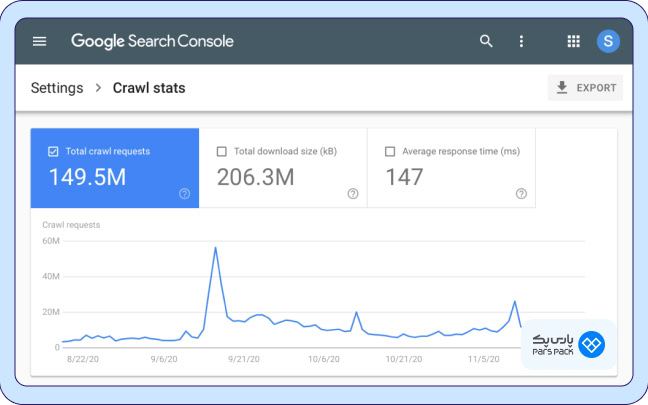

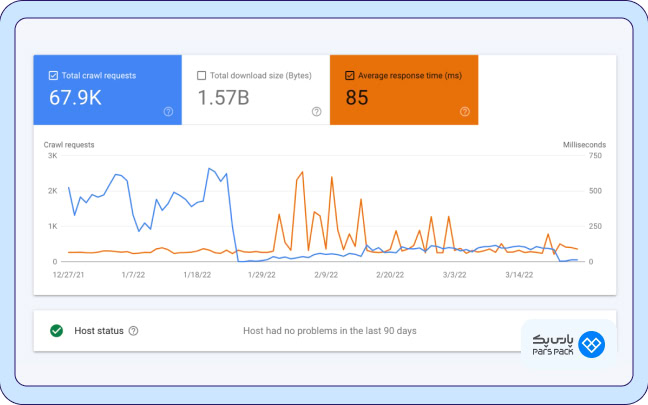

گزارش بودجه خزش از گوگل سرچ کنسول

گوگل سرچ کنسول (Google Search Console) گزارش مفصلی از وضعیت خزش URLهای سایت دارد که خطاها و مشکلات احتمالی کراولینگ (Crawling) را هم شامل میشود. برای دسترسی به این گزارش، از منوی سمت چپ روی Settings کلیک کنید. در ردیف مربوط به Crawl stats، روی گزینه «Open Report» کلیک کنید. این نمودار وضعیت کرال باجت را در 90 روز گذشته نشان میدهد.

نمودار خزش در طول زمان

کاربرد باکسهای بالای نمودار عبارت است از:

- Total crawl requests: تعداد کل درخواستهای خزش در 90 روز گذشته.

- Total download size: مجموع دادههایی که خزندههای گوگل هنگام دسترسی به وبسایت در یک دوره خاص دانلود کرده است.

- Average response time: میانگین مدت زمانی که سرور وبسایت به درخواست خزنده پاسخ میدهد (برحسب میلیثانیه).

وضعیت هاست (Host Status)

اگر در این قسمت پیام «Host had no problems in the last 90 days» را میبینید، یعنی هاست شما هیچ مشکلی برای خزش ایجاد نکردهاست. اما اگر پیامی مانند «Host had problems in the past» را دیدید، یعنی هاست شما گاهی اوقات نتوانسته به درخواستهای خزش گوگل پاسخ دهد. درهرصورت میتوانید روی این پیام کلیک کنید تا جزئیاتش را ببینید.

گروهبندی درخواستهای خزش (Crawl requests breakdown)

در این بخش، درخواستهای خزش را بر اساس دستهبندیهای مختلف دارید که آنها را در جدول زیر میبینید. با کلیک روی هر یک از درخواستها در سرچ کنسول، میتوانید تاریخ و URLهای کرالشده را ببینید.

| نوع درخواست خزش | کارکرد | مثال | اهمیت |

| By response | دستهبندی بر اساس پاسخ سرور |

|

رفع کدهای وضعیت اشتباه برای صرفهجویی در کرال باجت |

| URL File Type | دستهبندی بر اساس نوع فایل کرالشده |

|

جلوگیری از کرالشدن مکرر فایلهای غیرضروری یا سنگین با مسدودسازی آنها در Robots.txt |

| Purpose of the Request | دستهبندی بر اساس هدف خزش |

|

جلوگیری از درخواستهای زیاد Discovery که نشاندهنده تغییرات بیشازحد است. |

| Googlebot Type | دستهبندی بر اساس نوع گوگلبات |

|

اولویت قرار دادن نسخه موبایل (به دلیل Mobile-first indexing بودن گوگل) |

آمارگیری از وضعیت کرال باجت با ابزارهای سئو

یکی از مهمترین مباحث آموزش کرال باجت، کار با ابزارهای آماردهی است. در کنار گوگل سرچ کنسول که بالاتر دیدید، SEMrush و Ahrefs نیز از بهترین ابزارهای آمارگیری بودجه خزش است. در ادامه نحوه مشاهده گزارش این ابزارها را میبینید.

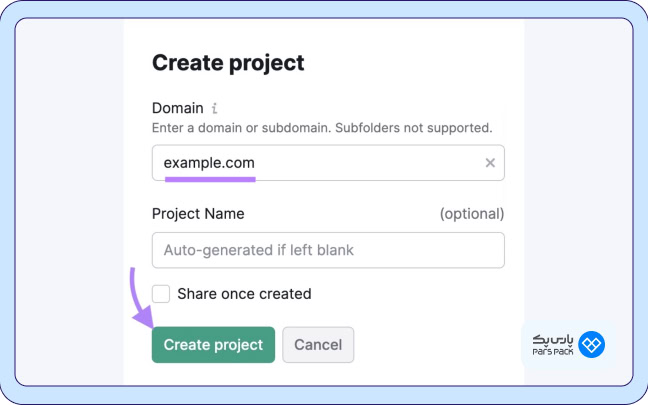

آمارگیری خزش سایت با SEMrush

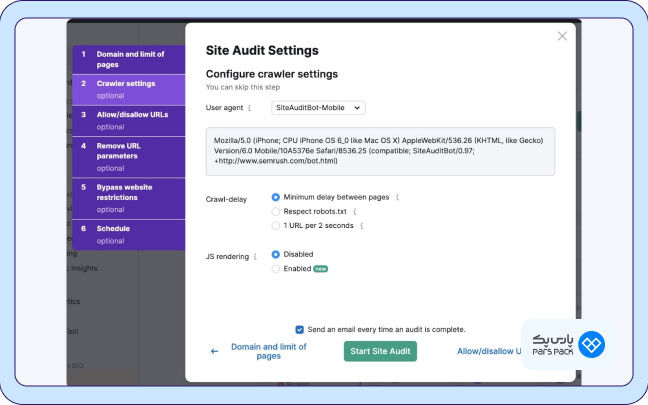

قابلیت «Site Audit» یا حسابرسی سایت در SEMrush گزارش بسیار مفیدی از کرال باجت گوگل ارائه میدهد. در حساب رایگان این ابزار میتوانید تا ۱۰۰ لینک سایت خود را حسابرسی کنید. برای مشاهده این گزارش، مراحل زیر را طی کنید:

- روی Site Audit در منوی سمت چپ کلیک کنید (با فرض این که قبلاً وبسایت را بهعنوان پروژه تعریف کردهاید).

- تعداد صفحاتی را که میخواهید بررسی شود، بههمراه منبع کرال مشخص کنید.

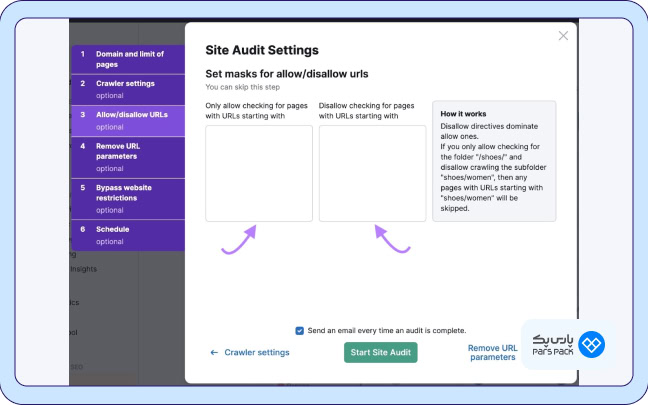

- میتوانید روی گزینه «Allow-disallow URLs» نیز کلیک کرده و دسترسی به بعضی URLها را محدود کنید.

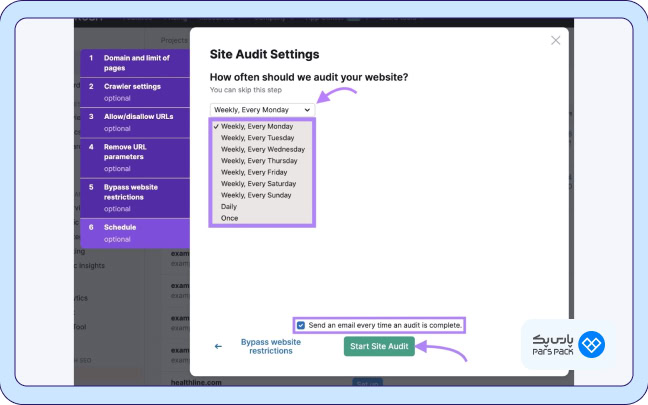

- در نهایت تعیین کنید که میخواهید بررسی کرال باجت توسط Site Audit هر چند وقت یک بار انجام شود.

- روی Start Site Audit کلیک کنید.

گزارش «Overview» مربوط به Site Audit، تمام دادههایی را خلاصه میکند که رباتها در طول خزش جمعآوری کردهاست. ابزارک «Crawled Pages» نیز تعداد صفحات کرالشده و صفحات بدون مشکل و مشکلدار را نشان میدهد.

برای مشاهده اطلاعات دقیقتر نیز میتوانید وارد بخش «Crawlability» شده و روی «View details» کلیک کنید.

در این گزارش، میتوانید ببینید که چه مقدار از بودجه خزش هدر رفته و چه مشکلاتی سر راه بودهاست (مانند ریدایرکتهای دائمی و موقت، محتوای تکراری، سرعت پایین و…). با کلیک روی هر یک از نوارها، لیستی از صفحاتی را میبینید که این مشکل را داشتهاست.

بسته به نوع مشکل نیز اطلاعاتی را در ستونهای مختلف برای هر صفحه آسیبدیده میبینید.

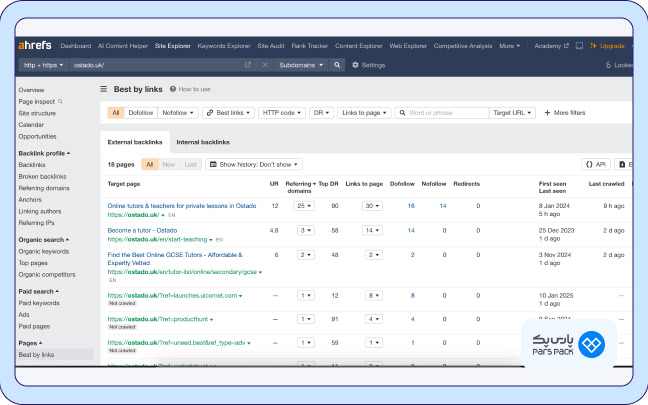

آمارگیری خزش سایت با Ahrefs

بررسی کرال باجت را میتوانید به کمک چند قابلیت در ابزار Ahrefs نیز انجام دهید. یکی از مهمترین گزارشهای این زمینه «The Best Pages by Incoming Links» است. چراکه همانطور که اشاره کردیم، لینکهای داخلی از مهمترین عوامل مؤثر بر کرال باجت است.

در این بخش میتوانید ببینید کدام صفحات بهترین لینکسازی و در واقع بهترین وضعیت را برای کرالشدن دارد. همینطور تاریخ آخرین باری که Ahrefs صفحات شما را کرال کرده را هم میبینید.

به اگر به دنبال پیدا کردن فرصتهای طلایی برای لینکسازی داخلی هستید، میتوانید از بخش «Internal Link Opportunities» استفاده کنید.

قابلیت کاربردی دیگر Ahrefs، بخش «Internal Pages» آن است. در این گزارش وضعیت لینکهای داخلی مرتبط با صفحات ریدایرکتشده را میبینید. اگر لینک داخلی به صفحهای دارید که ریدایرکت شده، بهتر است لینک را از اساس به همان صفحه مقصد بدهید تا رباتهای خزنده مسیر کمتری را طی کند.

جمعبندی

بودجه خزش (Crawl Budget) یکی از جنبههای پنهان، اما بسیار مهم در مدیریت سئو است که میتواند بهشکل مستقیم بر رتبهبندی سایت در نتایج جستجو تاثیر بگذارد. با نظارت دائم بر وضعیت کرالینگ (crawling) و حذف صفحات بیارزش، مدیریت پارامترهای URL ، بهینهسازی لینکدهی و… میتوانید رباتهای خزنده گوگل را به سمت محتوای کلیدی هدایت کنید. فراموش نکنید که هر اقدام کوچکی برای بهینهسازی سایت، میتواند به بازدهی این بودجه ارزشمند کمک کند.

سؤالات متداول

آیا ما باید روی گرفتن بودجه کرال تمرکز کنیم؟

اگر وبسایتی بزرگ با بیش از ۱ میلیون صفحه و بهروزسانی هفتگی یا وبسایتی با بیش از ۱۰۰۰۰ صفحه با بهروزسانی روزانه یا صفحاتی با مشکل جدی کرال دارید، باید نگران این پارامتر باشید.

چطور میتوان نرخ خزش سایت را افزایش داد؟

حذف ریدایرکتهای اضافه، صرفهجویی در بودجه خزش، بهینهسازی سرعت سایت، بهروزرسانی نقشه سایت، طراحی ساختار مناسب وبسایت و حذف محتواهای تکراری.

چرا باید لینکهای شکسته (Broken link) را اصلاح کرد؟

رباتهای خزنده گوگل لینکی را دنبال میکند که در نهایت به یک خطا (مانند خطای 404) میرسد. بنابراین، در عمل بودجه خزش صرف کاری بیارزش شدهاست.

آیا بودجه خزش (Crawl Budget) برای سئوی سایت مهم است؟

بله، بودجه خزش بالاتر، صفحات را سریعتر ایندکس و رتبهبندی میکند و استراتژیهای سئو را زودتر به نتیجه میرساند.